Analyse de Scène Auditive

EN | FR

L'analyse de la scène auditive décrit la manière dont notre système perceptif analyse la vibration complexe entrante (le son) afin de produire une représentation significative de l'environnement. Elle implique le processus de regroupement ou de séparation des événements sonores dans le temps, que l'on appelle le flux auditif. Les éléments peuvent être regroupés (intégration), séparés en couches (ségrégation) ou séparés en événements successifs (segmentation). Plusieurs principes servent de « guides » au flux auditif, notamment l'harmonicité, la synchronisation des débuts, la comodulation de fréquence, la comodulation d'amplitude et la localisation de la source.

Ce spectrogramme représente un extrait de 15 secondes de la composition électroacoustique multimouvements à grand format Clair de Terre (1999) de Robert Normandeau, [ancien] partenaire d'ACTOR. Le mouvement dont est tiré cet extrait est appelé « Micro-montage » et la musique est à la mesure de son titre : de nombreux événements sonores brefs sont juxtaposés ou superposés dans un court laps de temps. Écoutez ce clip et vous entendrez un grand nombre, presque écrasant, d'événements sonores provenant de nombreuses sources différentes, déployés si rapidement qu'il peut être difficile de les suivre tous.

Ce qui soulève la question intéressante suivante : comment faire pour en garder la trace ? Comment le système auditif donne-t-il un sens aux vibrations de l'air incroyablement complexes et en perpétuelle évolution qui atteignent l'oreille ? Dans cet extrait, j'entends des accords qui s'écrasent, le vent qui siffle, des oiseaux qui gazouillent, une moto qui tourne à plein régime, et bien d'autres sources sonores que je reconnais vaguement mais que je suis bien en peine de nommer. Bien que cette palette sonore particulière se produise dans le contexte d'une pièce de musique électroacoustique, l'expérience d'être bombardé par de nombreux sons différents est familière à ce que le psychologue américain William James appelait « la confusion florissante et bourdonnante » de la vie quotidienne. Comment le système auditif sépare-t-il toutes ces sources en unités perceptives distinctes ?

Le processus qui consiste à décomposer le signal sonore incident en une représentation significative de l'environnement est appelé analyse de la scène auditive. Une explication complète de l'analyse de scène auditive dépasse le cadre d'un article de blog — le livre dans lequel Albert Bregman a donné à cette idée son explication la plus complète fait près de 800 pages — mais nous pouvons présenter ici quelques concepts de base.

Comme le montre clairement le spectrogramme ci-dessus, nous traitons souvent de nombreuses fréquences incidentes en même temps, et le système auditif doit décider lesquelles vont ensemble (intégration) et lesquelles doivent être séparées (ségrégation). Par exemple, dans la situation bruyante d'une rue d'une ville à un moment donné, certaines des composantes sonores qui atteignent vos oreilles peuvent appartenir à une moto qui passe, d'autres au bruit ambiant de la circulation, et d'autres encore aux voix des personnes qui se trouvent sur le trottoir à côté de vous : votre système auditif déchiffre ce qui correspond à quoi. En outre, le système auditif doit regrouper les composantes sonores reçues en unités délimitées dans le temps (segmentation), par exemple des notes de musique, et décider lesquelles regrouper en séquences étendues telles que des mélodies. C'est ce qu'on appelle le flux auditif.

Aussi compliqué que cela puisse être, il existe heureusement relativement peu de principes qui guident le système auditif dans cette tâche. Il s'agit des principes suivants :

Harmonicité : Les fréquences (ou partiels) liées par des rapports entiers simples ont tendance à se regrouper. Par exemple, si la scène auditive contient des fréquences à 110 Hz, 220 Hz et 330 Hz (n, 2n, 3n), le système auditif aura tendance à les fusionner en un seul son complexe, alors que les fréquences à 110 Hz, 201 Hz et 350 Hz, qui ne sont pas liées par des rapports simples, sont moins susceptibles de fusionner. Pour mieux comprendre le principe d'harmonicité, voir cet exemple tiré du site web d'Albert Bregman.

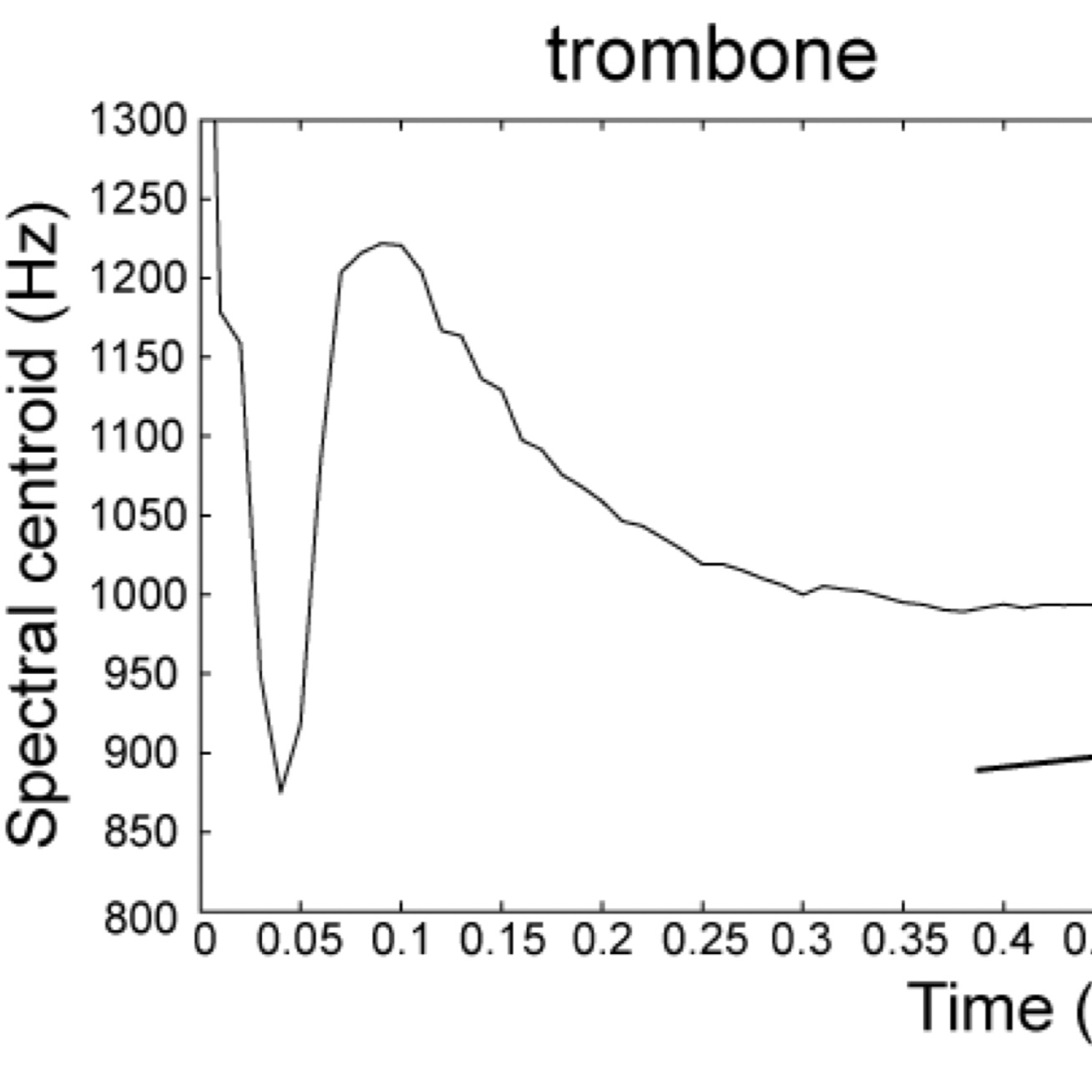

Synchronisation de départ : Les composantes sonores qui commencent dans une fenêtre temporelle très courte d'environ 30 millisecondes ont tendance à se regrouper.

Modulation parallèle de fréquence : Les composantes sonores qui augmentent ou diminuent en parallèle ont tendance à se regrouper. Par exemple, vous pouvez entendre dans cet exemple comment notre système perceptif a tendance à regrouper les composantes d'un son complexe sur la base de leur comodulation de fréquence.

Modulation parallèle d'amplitude : Les composantes du son qui deviennent plus fortes ou plus faibles en parallèle ont tendance à se regrouper.

Emplacement de la source : Les composantes sonores qui proviennent du même endroit physique dans l'espace ont tendance à se regrouper. À titre d'exemple, cette démonstration montre comment nous avons tendance à intégrer ou à séparer les flux auditifs en fonction de l'emplacement perçu de leur source (panoramique).

La plupart du temps, nous n'avons pas conscience de ce processus et nous le considérons comme acquis. Mais avant que la scène auditive ne parvienne à votre conscience, une incroyable prouesse d'analyse pré-attentive a déjà converti la complexité vertigineuse des vibrations de l'air qui vous entoure en une image cohérente du monde.

Référence

Bregman, A. (1990). Auditory Scene Analysis : The Perceptual Organization of Sound. The MIT Press. https://doi.org/10.7551/mitpress/1486.001.0001

Plus d'essais sur le lexique timbral

Sur cette page: